DeepmineAI olarak, Web sitelerinden veri kazıma kapsamında Hepsiemlak platformundan İstanbul konut verilerini indirdik. Çalışmada, veri kazıma yöntemini kullandık. Araştırma amaçlı olan bu proje ile yaklaşık 30.000 konutun bilgilerini çektik. Elde edilen bu bilgilerden detaylı bir veri seti oluşturduk.

Bu yazımızda, veri kazıma sürecimizi ve kullanılan teknikleri anlatacağız. Bu yazı, internetten veri kazımak isteyenler için rehber olacaktır.

Veri Kazıma Nedir ve Neden Önemlidir?

Veri kazıma (web scraping), web sitelerinden veya diğer dijital kaynaklardan otomatik olarak veri toplama işlemidir. Bu işlem, internetteki verileri çekmek için kullanılır. Veri kazıma, özellikle şu durumlarda tercih edilir:

- Web sitelerinde açıkça sunulan ancak indirme seçeneği bulunmayan verilere erişmek.

- Büyük ölçekli veri setlerini hızlı ve otomatik bir şekilde toplamak.

- Rekabet analizi, fiyat karşılaştırması veya piyasa trendlerini izlemek.

Güncel Durum:

- Veri kazıma, özellikle e-ticaret, emlak, finans ve pazarlama sektörlerinde yaygın olarak kullanılıyor.

- Yapay zeka ve makine öğrenmesi modellerini eğitmek için büyük veri setlerine ihtiyaç duyulması, veri kazımanın önemini artırıyor.

- Ancak, web sitelerinin veri kazımaya karşı önlemler alması (CAPTCHA, IP engelleme vb.) bu süreci zorlaştırabiliyor.

- Etik ve yasal sınırlamalar da veri kazıma uygulamalarını dikkatli bir şekilde yürütmeyi gerektiriyor.

Web Sitelerinden Veri Kazıma Projenin Detayları

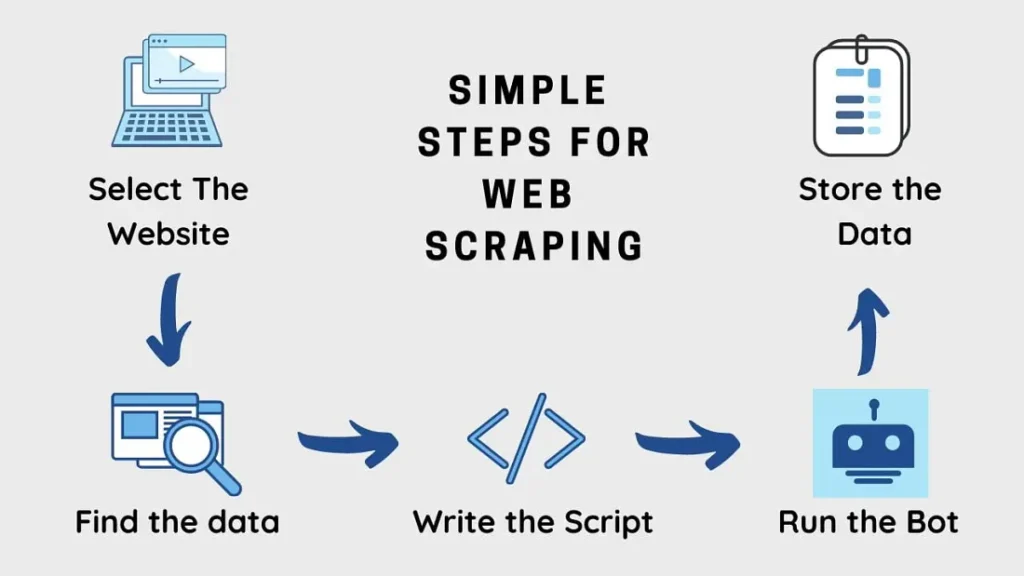

Projemizde, Python programlama dili ve Selenium, BeautifulSoup, Pandas gibi kütüphaneleri kullandık. Hepsiemlak üzerinden konut verileri otomatik olarak çektik. İşte projenin temel adımları:

- WebDriver ve Kullanıcı Ajanı Ayarları:

- Selenium ile tarayıcı otomasyonu sağladık.

- Kullanıcı ajanı değiştirilerek, web sitesine insan kullanıcı gibi erişim sağladık.

- Veri Kazıma İşlemi:

- Hepsiemlak’ın sayfa yapısı analiz edilerek, ilanların bulunduğu HTML elementleri tespit ettik. İlan bilgilerinin tutulduğu sınıf (class) yapılarını bulduk.

- Her ilandan başlık, oda sayısı, metrekare, bina yaşı, kat bilgisi, konum ve satılık/kiralık durumu gibi detaylar çektik.

- Veri Depolama ve Analiz:

- Toplanan veriler, Pandas DataFrame’ine dönüştürerek Excel dosyasına kaydettik.

Projenin Amacı ve Kapsamı

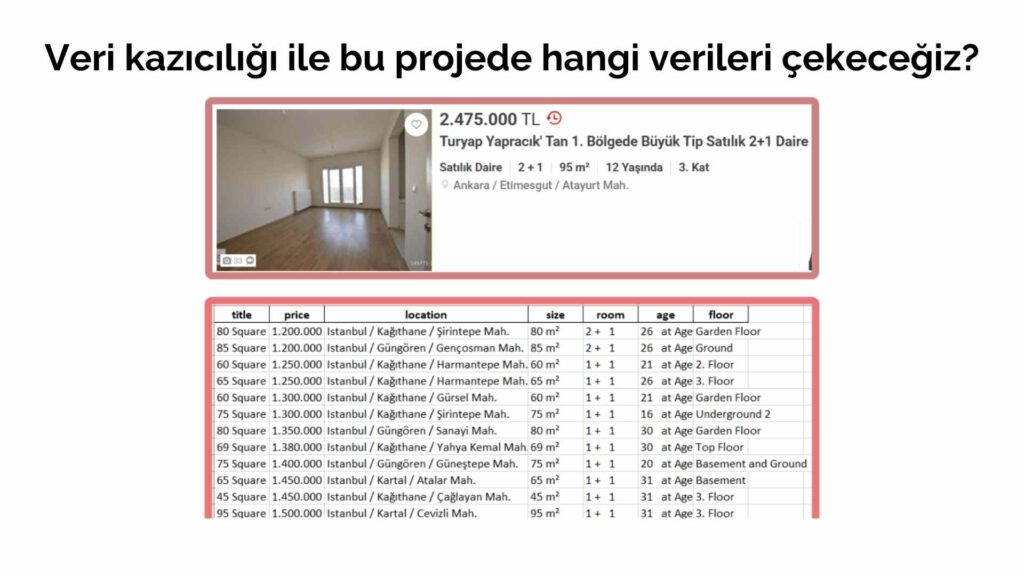

Bu proje ile Hepsiemlak platformundan İstanbul’daki satılık konut ilanlarını aşağıdaki bilgileri elde ettik:

- Title (İlan başlığı)

- Price (Fiyat)

- Location (Konum)

- Size (Metrekare)

- Room (Oda sayısı)

- Age (Bina yaşı)

- Floor (Kat bilgisi)

Videoda anlatılan veri kazıma kodlarını GitHub’dan indirebilirsiniz.

Veri Kazıma Süreci

1. Araçlar ve Teknolojiler

Bu projede veri kazıma işlemi için aşağıdaki araçları kullandık:

- Selenium: Dinamik web sitelerinden veri çekmek için kullanılan bir otomasyon aracı.

- BeautifulSoup: HTML ve XML verilerini ayrıştırmak için kullanılan bir kütüphane.

- Pandas: Elde edilen verileri düzenlemek ve analiz etmek için kullanılan bir veri işleme kütüphanesi.

- OpenPyXL: Çekilen verileri Excel dosyasına kaydetmek için kullanılan bir kütüphane.

Kodun Temel Özellikleri

- Dinamik Kullanıcı Aracısı İşleme : Betik, kullanıcı aracısı dizesini gerçek bir tarayıcıyı taklit edecek şekilde değiştirir; bu da anti-scraping mekanizmaları tarafından algılanmayı önlemeye yardımcı olur.

- Veri Temizleme Fonksiyonları : Çıkarılan verileri temizlemek ve biçimlendirmek, tutarlılık ve doğruluğu sağlamak için özel fonksiyonlar uyguladık.

- Tekrarlı Sayfa Gezintisi : Kod, listelemelerin birden fazla sayfasında tekrarlı bir şekilde gezinerek daha geniş bir veri kümesi toplanmasına olanak tanıdı.

- Veri Depolama : Son olarak toplanan veriler Pandas kullanılarak bir Excel dosyasında depolandı. Bu sayede bir sonraki aşama olan veri temizleme işlemi için gerekli ham veriler düzenli bir şekilde elde ettik.

2. Web Sitesine Erişim ve HTML Analizi

Hepsiemlak, dinamik içerik sunan bir web sitesi olduğu için Selenium kullanarak sayfaları yükledik ve sayfa kaynağını aldık. Daha sonra BeautifulSoup ile HTML içeriğini ayrıştırarak gerekli verileri çektik.

3. Veri Çekme Süreci

Verileri almak için aşağıdaki adımları izledik:

- Sayfa kaynağını alarak ilanları listeledik.

- İlanlardaki ilgili bilgileri seçerek temizleme işlemi gerçekleştirdik.

- Verileri liste halinde sakladık.

- Tüm sayfalardan veri çekme işlemini tekrarladık.

4. Veri Temizleme ve Formatlama

Çekilen verilerde, metin içindeki gereksiz karakterleri temizledik. Örneğin:

- “2 +\n 1” formatındaki oda sayılarını “2+1” formatına çevirdik.

- “14\n at Age” formatındaki bina yaşlarını sadece “14” olarak kaydettik.

5. Verilerin Excel Dosyasına Kaydedilmesi

Toplanan veriler Pandas DataFrame formatına çevrilerek ‘hepsiemlak_listings.xlsx’ dosyasına kaydedildi. Böylece analiz ve görselleştirme işlemleri için uygun bir format oluşturulmuş oldu.

Veri Analizi ve Kullanım Alanları

Toplanan veriler farklı amaçlar için analiz edilebilir:

- Fiyat Analizi: Konut fiyatlarının bölgesel dağılımını ve trendlerini belirlemek.

- Yatırım Analizi: Hangi bölgelerde daha fazla yatırım fırsatı olduğunu anlamak.

- Talep Analizi: En çok tercih edilen konut tiplerini belirlemek.

- Makine Öğrenmesi Modelleri: Gelecekteki fiyat tahminlerini yapmak için regresyon modelleri geliştirmek.

İşbirliği ve Gelecek Projeler

DeepMineAI olarak, veri kazıma, analiz ve yapay zeka destekli model geliştirme konularında iş birliklerine açığız. Emlak sektörü başta olmak üzere, büyük ölçekli veri analizi projeleriyle ilgilenen firmalar ve bireyler için özel çözümler sunuyoruz. Modern programlama teknikleri ve araçları kullanarak, internetten istenilen verileri etkili bir şekilde çekebiliyor, bu verileri işleyerek değerli içgörülere dönüştürüyoruz.

Veri, modern iş dünyasının temel taşıdır ve biz, bu gücü kullanarak yeni fırsatlar yaratmak için çalışıyoruz.

Eğer siz de veri kazıma, analiz veya iş birliği fırsatları hakkında daha fazla bilgi almak isterseniz, bizimle iletişime geçmekten çekinmeyin. Birlikte, verinin gücünü kullanarak yeni fırsatlar yaratabiliriz.